Es wurde Zeit mein eingemottetes Pinephone zu entstauben und auf den neusten Stand zu bringen. Ob sich das gelohnt hat oder nicht, könnt Ihr hier lesen.

Pinephone – 4 Jahre später

Zuerst mußte mal die alte Software auf den PC gesichert werden, außer Eure Daten sind Euch egal. Dazu bootet man das Pinephone per JumpDrive und schließt es per USB an den PC an. Jetzt habt Ihr ein Laufwerk und könnt Eure Daten einfach runterkopieren oder gleich die Partitionen per Laufwerketool oder DD und GZIP3 kopieren und archivieren. Bei der letzteren Methode verbraucht man mehr Speicherplatz, aber dafür kann man den alten Stand einfach wieder herstellen und „geht“.

Fedora 42 installieren

Als erstes muß man mal ein neues Fedora drauf installieren:

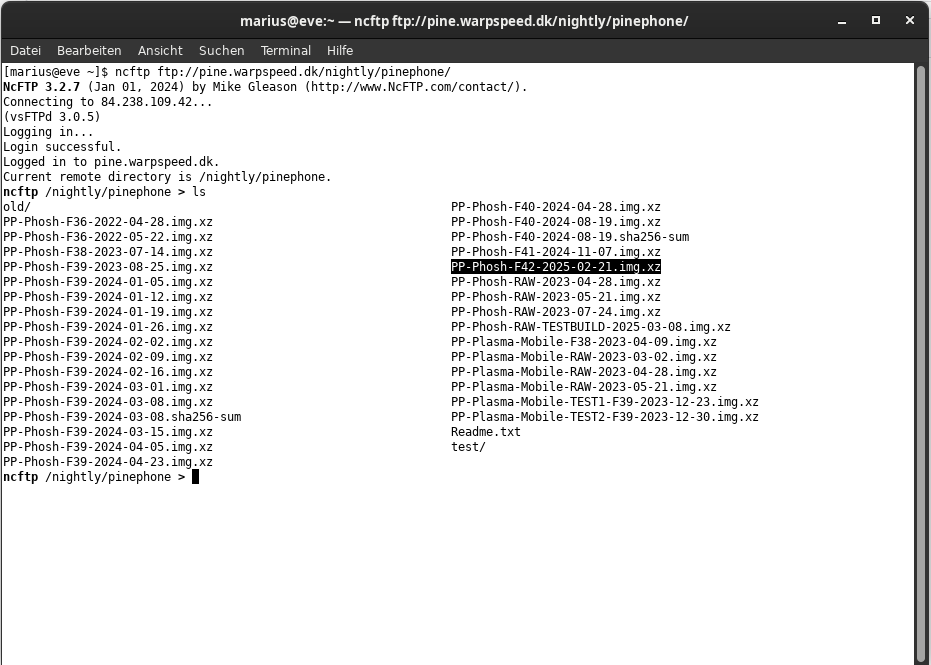

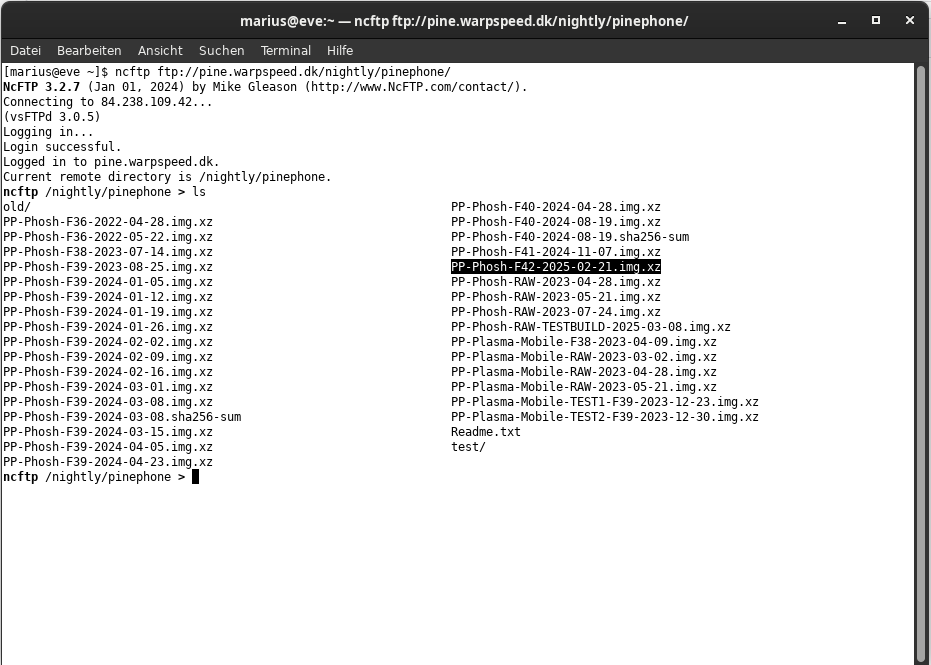

per NCFTP kann man auf der Seite ftp://pine.warpspeed.dk/nightly/pinephone/ einloggen und sich das aktuelle Image für Fedora 42 oder Eure avisierte Version ziehen.

per NCFTP kann man auf der Seite ftp://pine.warpspeed.dk/nightly/pinephone/ einloggen und sich das aktuelle Image für Fedora 42 oder Eure avisierte Version ziehen.

Mit „xz -d imagename.xz“ entpackt Ihr das Image auf der Platte. Vorsicht: Da braucht es Platz für.

Das ausgepackte Image wird per Laufwerke-Tool oder DD auf die EMMC des Pinephones geschrieben.

Wichtig: Die Batterie muß voll sein. Weil sonst der Saft während des Schreibens ausgeht, denn Strom und Daten gleichzeitig ist nicht drin per USB-C, jedenfalls nicht mit dem USB-A -> C Kabel 😉

Noch wichtiger: Wer mit DD oder dem Laufwerke-Tool nicht umgehen kann, ist selbst Schuld wenn Euer PC ein Pinephone sein will! Also penibel darauf achten, WO man was drauf schreibt!

Jetzt einfach von der EMMC Booten

Im Boot-Menü wählt Ihr einfach „Silent…EMMC“ aus und schon bootet das Pinephone in einen telefonüblichen Loginscreen, wo Ihr 1111 als Passwort eingebt. Die erste Amtshandlung sollte sein, diesen Pin zu ändern, was aber aus diversen Gründen nicht geht 🙂

Zum Einen weil die Terminalanwendung von Gnome direkt crasht, zum Anderen, weil wenn man denn per Software das Gnome-Terminal installiert hat und man endlich passwd eintippen kann, dies einem leider mitteilt, daß ein Passwort nur aus Zahlen nicht geht 😀

Wer also eine Telefonpin haben will, der muß erst einmal root werden und die /etc/security/pwquality.conf ändern. Wer das unbedingt will, wir das so ändern müssen:

minlen = 6

dcredit = 6

ucredit = 0

lcredit = 0

minclass = 0

maxrepeat = 0

maxclassrepeat = 0

dictcheck = 0

retry = 2

Jetzt kann man mit passwd auch einen Telefonpin eingeben. Natürlich könnt Ihr auch ein richtiges Passwort benutzen, aber dann wundert Euch nicht, wenn das bei der Eingabe schwierig bis unmöglich wird. Der spezielle Logingreeter fürs Pine kann nämlich nur Zahlen.

Davon mal abgesehen funktioniert das Pine einfach:

– Telefonieren geht

– SMS Senden geht

– Angerufen werden geht

– WIFI geht

– Mobiles Internet geht

– Bluetooth geht

– Hotspot … geht

– Kamera App geht nicht

– Video ruckfrei ansehen geht nicht

– GPS geht nicht

Die Kamera App „megapixels“ ist derzeit defekt, hat aber schon mal früher funktioniert. Das GPS Problem kann man aber leicht ändern.

Das Modem pimpen

Also erst mal, das GPS funktioniert per se. Leider ist es unpräzise, was dazuführt, daß ich angeblich in München wäre. Was es braucht sind GPS Korrekturdaten für die Satellitenbewegungen der letzten 30 Jahre.

Wenn Ihr es Euch einfach machen wollt, dann tragt einfach das Linux am Dienstag Repo ein:

$ vi /etc/yum.repos.d/lad.repo

[pva]

name=PVA $releasever – $basearch

baseurl=http://repo.linux-am-dienstag.de:80/$basearch/fedora/$releasever/

#metalink=https://mirrors.fedoraproject.org/metalink?repo=fedora-$releasever&arch=$basearch

enabled=1

metadata_expire=1d

#repo_gpgcheck=1

type=rpm

gpgcheck=1

gpgkey=http://repo.linux-am-dienstag.de:80/RPM-GPG-KEY-fedora-$releasever-$basearch

#skip_if_unavailable=False

dann „dnf makecache && dnf -y install modemmanager-agps“ eingeben und danach geht GPS dann auch präziser ~+-10m.

– GPS geht \o/

Videos ruckelfrei ansehen

Dazu müßte man MPV + libva-v4l2-reques installieren, aber das nutzt Euch nichts, weil Ihr ein script braucht:

$ mkdir -p .local/bin

$ vi .local/bin/mpv

#!/bin/bash

export PATH=/home/pine/.local/bin:/home/pine/bin:/usr/local/bin:/usr/bin:/usr/local/sbin:/usr/sbin

wlr-randr –output DSI-1 –transform 270

export LIBVA_DRIVER_NAME=v4l2_request

export LIBVA_V4L2_REQUEST_VIDEO_PATH=/dev/video0

export LIBVA_V4L2_REQUEST_MEDIA_PATH=/dev/media0

/usr/sbin/mpv –osd-duration=10000 –fs –hwdec=vaapi-copy –vo=gpu,drm –player-operation-mode=pseudo-gui „$1“

wlr-randr –output DSI-1 –transform normal

$ chmod 700 .local/bin/mpv

das es aber nur marginal besser macht, weil die Beschleunigung, mit der das Pine 2022 funktionierte, nicht mehr geht. Mehr dazu vermutlich später.

Das Pine verbraucht 1,5W im Leerlauf

Das Pinephone verbraucht derzeit ungefähr 1,5W wenn das Display aus ist und 2,5W wenn es an ist. Das ist min 1W mehr als es dürfte. Das könnte an einer schlechten Modemfirmware liegen, aber das ist bislang nur eine Vermutung.

Fakt ist, in dem Zustand hält es nur einen Tag, selbst wenn es in den Suspend geht, was es ohne SuspendGuardian nur sehr träge tut. Die Probleme, die aus einem alten SuspendGuardian Servivefile entstanden sind, werden heute Abend Thema bei Linux am Dienstag sein.

P-BOOT konfigurieren

Damit Ihr nicht unabsichtlich von der SD Karte bootet, was viel länger dauert, hier ein Tip:

Das File /boot/pboot/boot.conf.sh muß am Ende so geändert werden, wozu ich die Zeilen mit dem SD Boot ganz entfernt habe.

…

no = 0

name = Fedora Rawhide silent (eMMC)

atf = fw.bin

dtb = ../allwinner/sun50i-a64-pinephone-1.1.dtb

dtb2 = ../allwinner/sun50i-a64-pinephone-1.2.dtb

linux = ../Image

bootargs = $serial $root_emmc $silent $common splash rhgb plymouth.ignore-serial-consoles vt.global_cursor_default=0

splash = files/fedora.argb

no = 1

name = Fedora Rawhide verbose (eMMC)

atf = fw.bin

dtb = ../allwinner/sun50i-a64-pinephone-1.1.dtb

dtb2 = ../allwinner/sun50i-a64-pinephone-1.2.dtb

linux = ../Image

bootargs = $linux_con $serial $root_emmc $verbose $common

splash = files/fedora.argb

no = 2

name = Fedora Rawhide / previous kernel (eMMC)

atf = fw.bin

dtb = ../allwinner/sun50i-a64-pinephone-1.1.dtb

dtb2 = ../allwinner/sun50i-a64-pinephone-1.2.dtb

linux = ../Image-old

bootargs = $linux_con $serial $root_emmc $verbose $common

splash = files/fedora.argb

no = 9

name = Jumpdrive (SD)

atf = fw.bin

dtb = jumpdrv/board-1.1.dtb

dtb2 = jumpdrv/board-1.2.dtb

linux = jumpdrv/Image

initramfs = jumpdrv/initramfs

bootargs = loglevel=0 silent console=tty0 vt.global_cursor_default=0

splash = files/jumpdrive.argb

EOF

Dann dürft Ihr einmal ./p-boot-reconf.sh ausführen und beim nächsten Boot ist dann die EMMC der erste Eintrag.

Nützliche Apps

Da wären einmal Firefox , Geary und LollyPop zu nennen. Es ist zwar schon ein Browser drauf, aber FIrefox kann die Kamera benutzen 😀 Geary ist auf einem Telefon einfach die beste Wahl, weil das Layout optimal ist und LollyPop ist auch gut zu bedienen, wenn man Musik hören will.

Mehr vom Pine in den kommenden Tagen

Das war es erstmal vom Pine. Als letzten Tip für Euch, vergeßt nicht SSH zu starten und richtig zu konfigurieren, das macht den Fernzugriff sehr viel entspannter!