Erfüllt Euch euer spracherkennender Assistent nicht mehr jeden Wunsch? Melden die Kollegen im Videochat vielleicht, daß Ihr schon wieder mal so leise seid, dabei hattet Ihr das erst gestern richtig eingestellt? Glückwunsch, entweder Ihr seid Opfer von „wir wissen es besser“ Idioten geworden die AGC eingebaut haben oder Euch hat ein Pipewire-Glitch erwischt.

Ups: Automatischen Microphone Gain aktiviert?

Alle paar Jahre muß man sich gegen einen dieser Trottel zur Wehr setzen, die es für eine total geniale Idee halten, daß andere Menschen zu blöd sind Ihre Mikrofoneinstellungen richtig zu machen und bauen dann AGC ein (Automatic Gain Control) . Das dachte ich natürlich zu erst auch und habe hier einen nicht ganz erst gemeinten Rant geschrieben, der sich gewaschen hatte 🙂 was wirklich schade ist, daß Ihr den jetzt leider verpasst, ehrlich 😉 Aber es war halt nur ein komischer Bug.

Was ist passiert?

Das Eingabegerät meiner Webcam, das hier das Mikro mimt, fing wilde an, die Pegel von selbst anzupassen, je nachdem wie man gesprochen hat. AMGC halt. Chromium machte das auch mal eine Weile, zum Glück nur für sich, war trotzdem in der Videokonferenz eine Vollkatastrophe, weil man es nicht abschalten konnte. Pipewire ist zum Glück nicht Chromium.

Den Glitch beheben geht so:

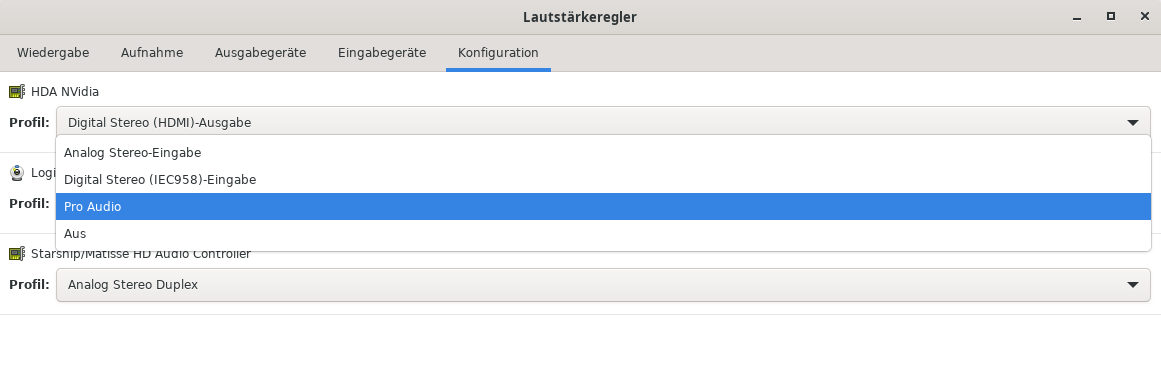

Macht mal den PulseAudio Lautstärkeregler auf -> Konfiguration

Dann stellt Euren Treiber auf Pro Audio um und Fertig. AGC gibt es für PRO AUDIO Experten nicht 🙂 Die Aufnahmeeinstellungen für Carola und andere Apps reagieren teilweise ganz übel darauf, daß das Device neu initialisiert wird, deswegen kann es sein, daß Ihr die Anwendungen, die das Geräte währenddessen benutzen, neu starten müßt.

Dann stellt Euren Treiber auf Pro Audio um und Fertig. AGC gibt es für PRO AUDIO Experten nicht 🙂 Die Aufnahmeeinstellungen für Carola und andere Apps reagieren teilweise ganz übel darauf, daß das Device neu initialisiert wird, deswegen kann es sein, daß Ihr die Anwendungen, die das Geräte währenddessen benutzen, neu starten müßt.

Wer es noch nicht gemerkt hat, das mit den Profis war natürlich nur ein Wortspiel 🙂 Mehr Infos zu PRO AUDIO gibt es hier.

Hat das auch Nachteile?

Ja, jetzt müssen alle Apps Ihren Pegel selbst regeln. Eure Carola lässt Euch da nicht im Stich, die Spracherkennung macht das schon. Andere Anwendungen wie Firefox könnten aber jetzt andere Pegel brauchen und müßten das selbst setzen. Das kann in die Hose gehen. Zum Glück musste es so nicht bleiben!

Aber, wie das Leben so spielt 😀

Am Ende half das:

- Auf PRO AUDIO umstellen,

Apps neustarten,

auf „Analog Stereo-Eingabe“ umstellen,

Apps nochmal starten.

AGC war deaktiviert. Es lohnt sich also den Ärger herunterzuschlucken, außer man hat ein Blog, und einfach mal zu schauen, ob es nicht doch einfach nur ein kleiner Initialisierungsbug war 😉 Natürlich wird jetzt wieder jemand fragen, wieso das Pipewires Schuld war, das offenbart der Fix, weil „PRO AUDIO“ und „Analog Stereo-Eingaben“ sogenannte Pipewireprofile sind, die das Gerät konfigurieren. Wenn man AGC mit einem Wechsel abschalten kann, war es wohl offensichtlich Pipewire selbst. Ich vermute ein skuriller Glitch beim Init des Gerätes. Mehr werden wir nie erfahren.