Es war wieder soweit. „Alle Jahre wieder“ – so hatte ich mir diesen Tag in meinem Kalender notiert. Nicht als Feiertag, sondern als Mahnung. Die Mahnung an den Punkt, an dem die Liebe zum Computer, die Freude am basteln, sich in einen Kampf gegen Staub, Schmutz und eine unbarmherzige Physik verwandelt.

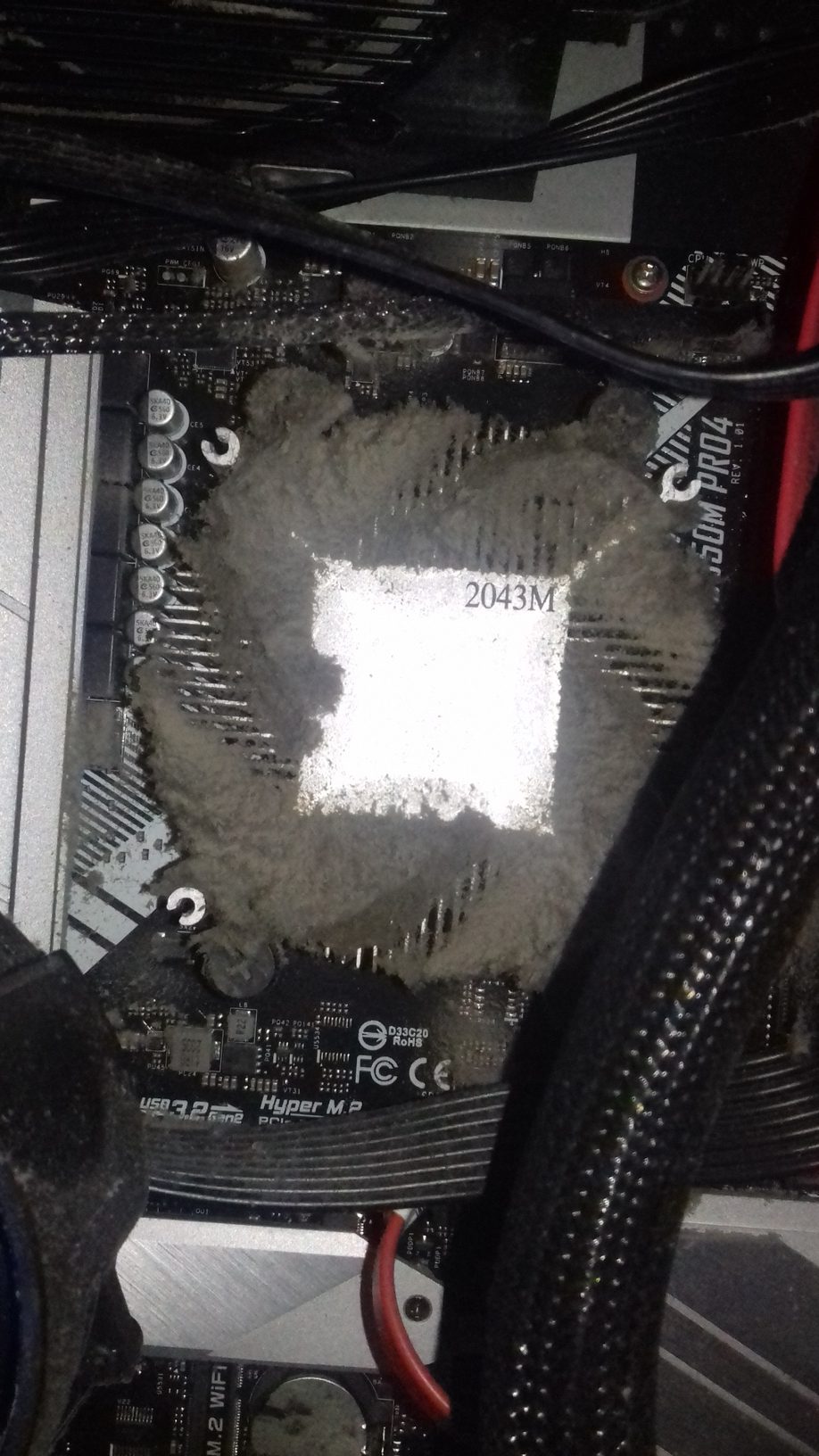

Es ging um den CPU-Lüfter. Es war nicht einfach nur staubig. Es war ein Monument aus Staub, einem Zeugnis jahrelanger

Vernachlässigung, das sich um die empfindlichen Komponenten meines Rechners gelegt hatte. Ein graues, hartnäckiges Gemisch aus Tierhaaren, Wollfasern, Staubflusen und wer weiß noch was. Und ich, in meiner Rolle als unbezahlter Wartungsmitarbeiter, musste diesen Horror beseitigen.

Die erste Hürde: Die vier Schrauben des Rotors. Schon beim ersten Versuch verzerrte sich die Schraube unter dem Druck meines Schraubendrehers. Sie biss sich in das Aluminium, als wollte sie mich aufhalten. Die zweite Schraube war noch schlimmer – sie schien festgerostet zu sein. Mit noch mehr Kraft versuchte ich es erneut, doch die Schraube drehte sich nur im Kreis. „Verdammte Axt!“, murmelte ich frustriert.

Die dritte Schraube drehte sich, aber nur sehr widerwillig. Sie fühlte sich an wie ein uraltes Artefakt, das nur für mich bestimmt war, um es zu quälen. Die vierte Schraube? Sie ging raus. Nur diese eine. Ein Triumph der Technik inmitten des Chaos. Die anderen drei saßen fest, unnachgiebig und bösartig.

Der erste Versuch, den Lüfter zu lösen, scheiterte. Er hing fest, von Staub und dem Zwang, mich zu ärgern. Nach dem zweiten Anlauf, bei dem er sich etwas gelöst hatte, ging es.

Jetzt kam der nächste Akt im Drama. Der gesamte Innenraum des Gehäuses war eine staubige Kathedrale. Ein Grauen, das sich über jeden Winkel und jede Komponente gelegt hatte. „Zeit für die Heavyweights“, dachte ich und holte den Staubsauger hervor.

Das Staubsauger-Massaker begann. Es war ein Tanz der Zerstörung, ein Kampf zwischen Mensch und Staub. Die Saugkraft des Staubsaugers wurde auf Mainboard, Grafikkarte, RAM-Riegel und Netzteil entfesselt. Es war ein wilder, unkontrollierter Tanz, bei dem ich befürchtete, etwas zu beschädigen. Aber es musste sein. Der Staub hatte zu lange gesiegt.

Nachdem der letzte Staubflusen-Sieg in den Tiefen des Staubsaugerbeutels verschwunden war, betrachtete ich das Ergebnis meiner Arbeit. Es war ein Triumph. Es war ein Sieg. Es war ein verstaubter Sieg, der mit einem Heulen aus dem Staubsauger endete. Aber es war auch eine Erinnerung. Eine Erinnerung daran, dass alle Jahre wieder der Kampf gegen den Staub neu beginnt. Und dass ich, als unbezahlter Wartungsmitarbeiter, dazu verdammt bin, ihn zu kämpfen.

Frohe Weihnachten,

Euer Weihnachtstechniker